クローズドキャプションは、プレゼンテーションやライブイベントにおけるアクセシビリティ、エンゲージメント、そして情報保持率を向上させる効果的な手法です。これに加え、動画ストリーミングにおける動画視聴習慣の変化も相まって、ライブイベントやビジネスミーティングにおけるAIを活用したキャプションの導入が近年加速しています。

しかし、独自の会議やイベントのプロバイダーを選択する場合、最もよく尋ねられる質問は、「自動ライブキャプションの精度はどの程度ですか?」です。

簡単に答えると、理想的な条件下では、音声言語の自動字幕は、単語誤り率 (WER) で評価すると最大 98% の精度を達成できます。

はい、少し長くて複雑な答えがあります。この記事では、精度の測定方法、精度に影響を与える要因、そして精度をさらに高める方法について概要を説明します。

この記事で

数字を詳しく見ていく前に、少し立ち止まって自動字幕の仕組みを見てみましょう。

自動字幕の仕組み

自動字幕

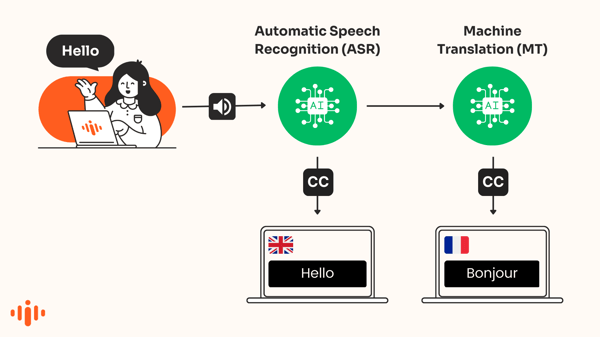

自動字幕機能は、音声をテキストに変換し、音声と同じ言語でリアルタイムに画面に表示します。ASR(自動音声認識)は、音声の書き起こしを作成するために使用される人工知能の一種です。

「音声テキスト変換」とも呼ばれるこの技術は、音声内の単語を自動的に認識し、音声をテキストに変換します。

AI翻訳字幕

AIを搭載した翻訳エンジンは、異なる言語で表示される字幕を自動翻訳します。これは、機械翻訳字幕または機械翻訳キャプションとも呼ばれます。

おすすめの記事

次のイベントにライブキャプションを追加することを検討すべき理由

この記事では、自動字幕について解説します。AI翻訳字幕の精度について詳しく知りたい方は、こちらの記事。

字幕の品質が良いとされる条件は何ですか?

連邦通信委員会 (FCC) は、字幕が「優れている」かどうかを判断するための重要な特性を 2014 年に確立しました。

- 正確性- 字幕は可能な限り話された言葉と一致していなければなりません

- 完全性- キャプションは、放送の最初から最後まで、可能な限り完全に掲載されます。

- 配置- キャプションは重要な視覚コンテンツをブロックせず、読みやすいです。

- 同期- 字幕はオーディオ トラックに合わせて読みやすい速度で表示されます。

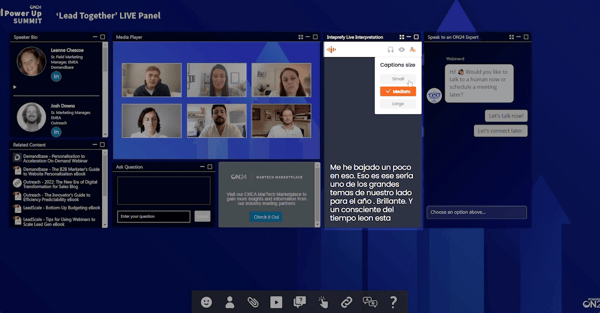

画像: ウェビナー中の AI 翻訳ライブキャプション

精度に影響を与える要因は何ですか?

選択されたAIエンジン

すべての音声テキスト変換エンジンが同じ結果を生み出すわけではありません。一般的に優れているエンジンもあれば、特定の言語に特化しているエンジンもあります。また、同じエンジンを使用していても、アクセント、ノイズレベル、トピックなどによって結果が大きく異なる場合があります。

そのため、Interprefyでは常にトップクラスのエンジンをベンチマークし、どのエンジンが最も正確な結果を生成するかを判断しています。その結果、Interprefyは、レイテンシやコストといった側面を考慮しながら、特定の言語に最適なソリューションをユーザーに提供できます。理想的な設定では、複数の言語で最大98%の精度を一貫して達成しています。

オーディオ入力品質

自動音声認識技術が高品質な出力を生成するには、高品質な入力が必要です。それは簡単です。音声と音声の品質と明瞭度が高ければ高いほど、結果も良くなります。

- オーディオ品質 -会議通訳と同様に、コンピューターの内蔵マイクなどの質の悪いオーディオ入力ハードウェアは悪影響を及ぼす可能性があります。

- 明瞭なスピーチと発音 -大きな声で、テンポよく、明瞭に話すプレゼンターには、通常、より正確な字幕が付けられます。

- 背景ノイズ -大きな騒音、犬の吠え声、紙をめくる音などがマイクに拾われると、オーディオ入力の品質が著しく低下する可能性があります。

- アクセント -珍しいアクセントや強いアクセントを持つ話者や非ネイティブ話者は、多くの音声認識システムにとって問題を引き起こします。

- 重複した発言 - 2 人の人が互いに話し合っている場合、システムが正しい発言者を正しく認識するのは非常に困難になります。

おすすめの記事

Zoom、Teams、Interprefy のキャプションの精度はどのくらいですか?

自動字幕の精度を測定する方法

ASR の精度を測定する最も一般的な指標は、話者の実際の書き起こしと ASR 出力の結果を比較する Word Error Rate (WER) です。

たとえば、100 語のうち 4 語が間違っている場合、精度は 96% になります。

単語誤り率(WER)の理解

WER は、音声認識システムによって生成されたトランスクリプト テキストと、人間によって生成された参照トランスクリプト (真実) 間の最短距離を決定します。

WERは、正しく識別された単語列を単語レベルでアラインメントし、参照テキストとトランスクリプトテキストを完全にアラインメントするために必要な修正(置換、削除、挿入)の総数を計算します。WERは、必要な調整数と参照テキストの総単語数の比率として計算されます。一般的に、WERが低いほど、音声認識システムの精度が高いことを示します。

単語誤り率の例: 91.7% の精度

単語エラー率が 8.3%、つまり精度が 91.7% の例を取り上げ、音声の元の書き起こしと ASR によって作成された字幕の違いを比較してみましょう。

| オリジナルのトランスクリプト: | ASR字幕出力: |

| たとえば、私は、必須事項の使用はごく限定的であってほしいと思っていますが、ある特定の点についてより詳細に述べたいと思います。求めることは、非常に有害な影響を及ぼす可能性があると私は懸念しています。 | 例えば、私も例外の使用は極めて限定的なものにとどめてほしいと思っていますが、ある特定の点についてより詳しく説明すると、 求めることは、非常に有害な影響を及ぼす可能性があると懸念しています。 |

この例では、キャプションに 1 つの単語が抜けており、4 つの単語が代用されています。

- 対策: {'一致': 55、'削除': 1、'挿入': 0、'置換': 4}

- 置換: [('too', 'do'), ('use', 'used'), ('exemptions', 'essentials'), ('the', 'i')]

- 削除: ['would']

したがって、単語エラー率の計算は次のようになります。

WER = (削除 + 置換 + 挿入) / (削除 + 置換 + 一致) = (1 + 4 + 0) / (1 + 4 + 55) = 0.083

WERはエラーの性質を無視する

上記の例では、すべてのエラーが同様に影響を与えるわけではありません。

WERの測定は、特定のエラーの関連性や重要性を示さないため、誤解を招く可能性があります。同じ単語の別の綴り(movable/moveable)などの単純なエラーは、読者にエラーと認識されることはほとんどありませんが、代替(exemptions/essentials)の方が影響が大きい場合があります。

特に高精度の音声認識システムにおけるWER値は誤解を招く可能性があり、必ずしも人間の正確さの認識と一致するとは限りません。人間にとって、90%と99%の間の精度レベルの違いを区別することはしばしば困難です。

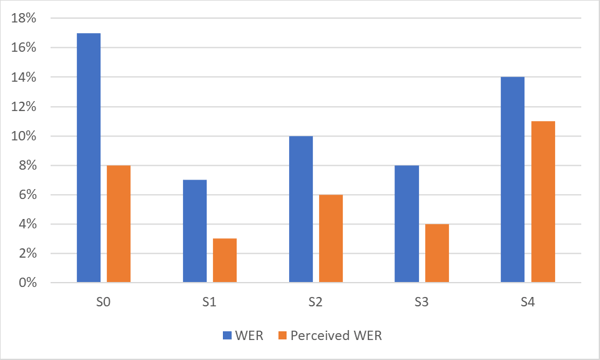

知覚される単語誤り率

Interprefyは、独自の言語固有のASRエラー指標「知覚WER」を開発しました。この指標は、すべてのエラーではなく、人間の音声理解に影響を与えるエラーのみをカウントします。知覚エラーは通常WERよりも低く、時には50%に達することもあります。知覚WERが5~8%であれば、通常、ユーザーにはほとんど気づかれません。

下のグラフは、高精度ASRシステムのWERと知覚WERの差を示しています。同じ言語の異なるデータセット(S0~S4)におけるパフォーマンスの違いに注目してください。

グラフに示されているように、人間が知覚する WER は、統計的な WER よりも大幅に優れていることがよくあります。

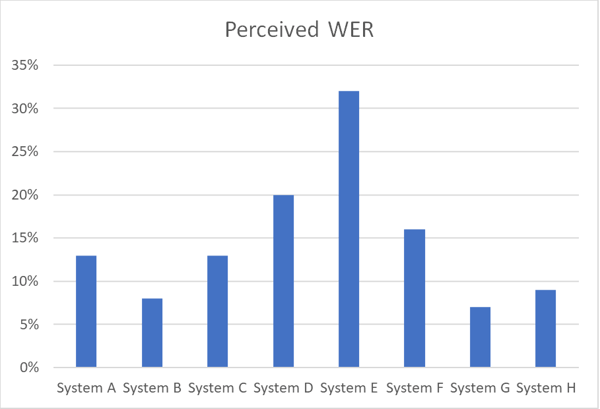

以下のグラフは、知覚 WER を使用して特定の言語の同じ音声データ セットを処理するさまざまな ASR システム間の精度の違いを示しています。

ライブイベントに驚くほど正確なクローズドキャプションを

独自の技術ソリューションとお客様への配慮により、自動字幕の精度は97%に達しています。Interprefy AIデリバリー責任者、アレクサンダー・ダヴィドフ

イベント中に高精度の自動字幕を作成したい場合は、次の 3 つの重要な点を考慮する必要があります。

クラス最高のソリューションを使用する

すべての言語をカバーする既成のエンジンを選択するのではなく、イベントの各言語に最適なエンジンを活用するプロバイダーを選択してください。

最高のエンジンがあなたに何を提供できるのか知りたいですか?記事をお読みください:ライブキャプションの未来:Interprefy AIがアクセシビリティをどのように強化するか

エンジンを最適化する

ブランド名、奇妙な名前、頭字語が適切にキャプチャされることを保証するために、AI にカスタム辞書を補完できるベンダーを選択してください。

高品質のオーディオ入力を確保する

音声入力が悪いと、ASRシステムは出力品質を達成できません。音声が大きく明瞭に捉えられていることを確認してください。

独自の AI キャプション品質評価を実行してみませんか?

その他のダウンロードリンク

その他のダウンロードリンク